Tegoroczna konferencja RSA Conference 2025 (RSAC) jasno pokazała, że świat cyberbezpieczeństwa zmienia się szybciej niż kiedykolwiek wcześniej. Przyszłość obrony przed zagrożeniami to już nie tylko firewalle i aktualizacje systemów. To codzienna walka z zaawansowanymi modelami AI, proliferacją tzw. „non-human identities” i potrzebą budowania silnych, odpornych więzi — zarówno w sensie technologicznym, jak i ludzkim.

Głównym motywem tegorocznej edycji była sztuczna inteligencja. W 2023 roku jedynie 5% zgłoszonych tematów dotyczyło AI. W 2025 – aż 40%. To zmiana rewolucyjna, która pokazuje, jak szybko AI weszła do codziennej praktyki — w cyberbezpieczeństwie zarówno jako narzędzie obronne, jak i realne zagrożenie. Eksperci zwracali uwagę na coraz większą rolę agentów AI, którzy potrafią działać autonomicznie, a czasem w sposób nieprzewidywalny. LLM-y mogą pomagać w wykrywaniu incydentów, ale też generować złośliwy kod lub wprowadzać do systemów nowe podatności. Z kolei narzędzia typu Retrieval Augmented Generation (RAG) stwarzają szansę na bezpieczne zarządzanie wiedzą – o ile zostaną odpowiednio zabezpieczone. Pojawił się nawet nowy termin: AIBOM – AI Bill of Materials, który ma na celu zwiększenie przejrzystości komponentów używanych w systemach AI, na wzór popularnych SBOM w oprogramowaniu.

Równolegle coraz więcej mówi się o non-human identities (NHI). Pracownicy korzystają z narzędzi AI, które posiadają własne uprawnienia i identyfikatory — tworząc tym samym nową warstwę ryzyka. W środowiskach chmurowych i hybrydowych trudno dziś jednoznacznie określić, kto (lub co) wykonuje operację na danych. Rosnący problem z zarządzaniem, uwierzytelnianiem i audytem aktywności NHI sprawia, że organizacje muszą wdrażać zupełnie nowe strategie bezpieczeństwa – takie, które obejmują nie tylko użytkowników, ale i „cyfrowych pomocników”. Wiele prezentacji dotyczyło tego, jak zabezpieczać NHI w architekturach RAG i jak budować wokół nich ramy zaufania.

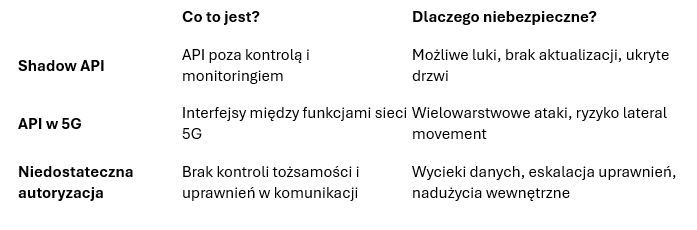

Kolejnym obszarem alarmowym były interfejsy API. W dobie GenAI to one stają się nowym wektorem ataku – często niezabezpieczonym, słabo monitorowanym, a jednocześnie niezwykle krytycznym. Eksperci omawiali zagrożenia związane z shadow API, podatności w API dostępnych w środowiskach 5G oraz wycieki danych z niedostatecznie autoryzowanych połączeń między komponentami systemu. Wnioski są jednoznaczne: każda firma korzystająca z AI musi przeprowadzić audyt swojego krajobrazu API i wdrożyć odpowiednią politykę bezpieczeństwa uwzględniające dynamiczny kontekst użycia danych.

Zaskakująco dużo uwagi poświęcono również problemom etycznym. Prelegenci wskazywali, że rozwój technologii nie może wyprzedzać regulacji i refleksji etycznej. Bez zrozumienia, jak AI wpływa na decyzje, jakie ryzyka niesie nadmierne zaufanie do modeli językowych i bez jasnych zasad odpowiedzialności — budujemy fundamenty pod kryzys zaufania. Wielu specjalistów apelowało o tworzenie wewnętrznych kodeksów etycznych i edukowanie zespołów nie tylko w zakresie technologicznym, ale również kulturowym i organizacyjnym. W tym kontekście pojawiały się również głosy o konieczności regulacji AI na poziomie europejskim i globalnym, np. poprzez rozszerzenie GDPR o komponenty AI.

Wszystkie te tematy łączy jedno przesłanie: bezpieczeństwo to nie tylko kwestia narzędzi, ale społeczności. RSAC 2025 wielokrotnie podkreślała znaczenie współpracy międzysektorowej, wymiany wiedzy i budowania odporności nie tylko technologicznej, ale i społecznej. Cyberbezpieczeństwo zaczyna się w szkołach, urzędach, małych firmach i rodzinach. Ochrona dzieci i seniorów, walka z cyfrowym wykluczeniem, rozwój kompetencji cyfrowych – to wszystko było obecne w tegorocznej edycji. To też przypomnienie, że najlepsze rozwiązania techniczne nie zastąpią edukacji, świadomości i współpracy.